Seit Jahren hören Hersteller, dass Daten ihre größte ungenutzte Ressource seien. Doch für viele scheint das Versprechen, Rohdaten in echte Erkenntnisse umzuwandeln, immer noch unerreichbar. Die Systeme wie ERP, MES, Qualität und mehr sind zwar vorhanden, aber das Ergebnis ist oftmals wenig überzeugend.

Die meisten Hersteller kämpfen nicht damit, dass sie zu wenig Daten haben. Das größere Problem ist, herauszufinden, was man mit den Daten machen kann und wie man sie rechtzeitig für die Entscheidungsfindung nutzbar macht. Eine kürzlich von Tech-Clarity und MESA International durchgeführte Umfrage unter mehr als 400 Herstellern weltweit macht dies deutlich. Mehr als die Hälfte gab an, dass ihre Daten unzuverlässig oder inkonsistent sind. Viele gaben an, dass sie bei Bedarf nur schwer auf Daten zugreifen können. Und andere wiesen darauf hin, dass die Zahlen, selbst wenn sie verfügbar sind, nicht so aufbereitet sind, dass sie den Mitarbeitern in den Betrieben helfen, Maßnahmen zu ergreifen.

Das ist kein guter Zustand. Besonders heutzutage, wo jede Minute Ausfallzeit oder jeder verpasste Einblick Umsatzeinbußen oder einen unzufriedenen Kunden bedeuten kann.

Warum Hersteller immer noch mit Daten kämpfen

Es sind die altbekannten Probleme. Die meisten Fabriken haben bereits Systeme zur Rückverfolgung der Leistung und der Qualität, aber das bedeutet noch nicht, dass die Daten verwertbar und vertrauenswürdig sind.

Wenn Daten nicht mit der richtigen Maschine, dem richtigen Bediener oder der richtigen Produktversion verknüpft sind, verlieren sie schnell an Aussagekraft. Und wenn verschiedene Systeme widersprüchliche Ansichten präsentieren, beginnt das Vertrauen in die Daten - und in die Erkenntnisse, die sie liefern sollen - zu schwinden. Aber die eigentliche Herausforderung liegt noch tiefer. Meistens ist nicht sofort klar, wonach man in einem Datensatz überhaupt suchen sollte, bis man sieht, wie alle Teile zusammenpassen. Deshalb ist der Kontext so wichtig. Um wirklich zu verstehen, was vor sich geht, müssen die Daten das gesamte Bild widerspiegeln: Produktdesign und -konfiguration, Prozessschritte, Personal, Ausrüstung, verbrauchte Materialien, Automatisierungsereignisse und mehr. Nur wenn diese Elemente sinnvoll miteinander verknüpft sind, kann die wahre Natur eines Problems - oder einer Chance - aus den Daten hervortreten.

Die leistungsstärksten Hersteller verfolgen einen anderen Ansatz. Sie bauen von Anfang an Kontext in ihre Daten ein. Das bedeutet, dass sie Prozessereignisse, Qualitätsergebnisse und Änderungen in Echtzeit erfassen und diese Daten nicht nur mit einem bestimmten Arbeitsauftrag verknüpfen, sondern auch mit dem zugehörigen Produktdesign und der Konfiguration, den Prozessschritten, der Ausrüstung, den verbrauchten Materialien und den in jeder Phase beteiligten Personen.

Einige Manufacturing Operations Software-Lösungen strukturieren die Daten nicht nur, sondern kontextualisieren sie bereits bei ihrer Erstellung. Jeder Datenpunkt wird automatisch mit dem richtigen Produkt, Prozess, Gerät, Bediener und Schritt im Arbeitsablauf verknüpft. Und das nicht nur in loser Verbindung - die Variablen des Produktionskontexts und die Qualitätsergebnisse können bis hinunter zu einzelnen Attributen innerhalb eines bestimmten Bauteils im CAD-Konstruktionsmodell verknüpft werden. Dank dieses integrierten Kontexts ist es nicht mehr erforderlich, Informationen aus verschiedenen Systemen zusammenzufügen, und es wird sichergestellt, dass die Informationen präzise und aussagekräftig sind und genau dann und dort zur Verfügung stehen, wo sie benötigt werden.

Was Top Performer anders machen

Die Studie verdeutlicht auch, was branchenführende Hersteller von allen anderen unterscheidet. Diese Unternehmen übertreffen ihre Konkurrenten in Bereichen wie First-Pass Yield, GAE, und Liefertreue. Aber dabei geht es nicht nur darum, die besseren Tools zu haben. Es geht darum, wie diese eingesetzt werden.

Top Performer:

- verwenden Dashboards, die für Bediener und nicht nur für Führungskräfte entwickelt wurden

- setzen vorausschauende Analysen ein, um Probleme zu vermeiden, anstatt sie zu erklären

- verbinden Prozess- und Produktdaten durchgängig miteinander

- setzen auf Data-Governance zur Sicherstellung von Konsistenz und Vertrauen

Und sie verstehen insbesondere, dass Analysen nur dann einen Mehrwert haben, wenn die zugrundeliegenden Daten präzise und aktuell sind.

Was diese Spitzenunternehmen auszeichnet, ist nicht nur der Zugriff auf die Daten. Es geht darum, wie diese Daten kontextualisiert und von Grund auf verwaltet werden. Anstatt sich auf isolierte Berichte oder Zusammenfassungen von Auftragslosen zu verlassen, generieren sie Erkenntnisse direkt aus Live-Produktionsdaten, die mit echten Prozessen verbunden sind. Auf diese Weise können sie Probleme früher erkennen, notwendige Anpassungen schneller vornehmen und sich kontinuierlich verbessern.

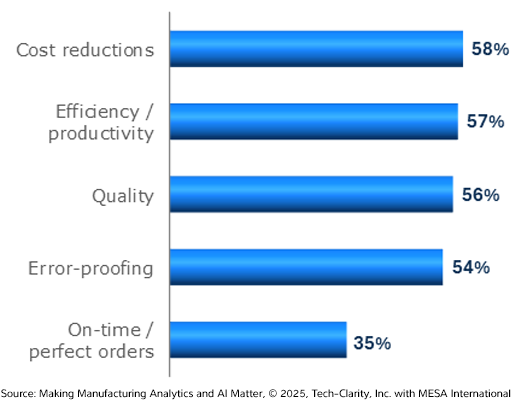

Es überrascht nicht, dass sich diese datengesteuerten Gewohnheiten direkt in messbaren Geschäftsergebnissen niederschlagen. Auf die Frage, in welchen Bereichen die Analytik die größten Auswirkungen hat, nannten die Hersteller folgende Bereiche:

Die wichtigsten Bereiche, die erheblich von Analysen profitieren

Am wichtigsten sind Kostensenkungen, dicht gefolgt von Verbesserungen in den Bereichen Effizienz, Qualität sowie Fehlersicherheit. Dies sind die möglichen Ergebnisse, wenn Hersteller über oberflächliche Berichte hinausgehen und beginnen, Erkenntnisse zur Steuerung der täglichen Arbeit zu nutzen.

Erkenntnisse in einen echten Geschäftswert umwandeln

Sobald die richtigen Daten in den richtigen Händen sind, sind die Auswirkungen unmittelbar spürbar.

Kostensenkung war der am häufigsten genannte Vorteil. Es ist keine Überraschung, dass Daten helfen, Verschwendung bei Prozessen, Materialien und Arbeit zu erkennen. Aber das ist noch nicht alles. Die Produktivität steigt, denn Bediener und Vorgesetzte müssen keine Zeit mehr mit der Suche nach Informationen verschwenden oder in letzter Minute auf unangenehme Überraschungen reagieren.

Die KI-gesteuerte Qualitätsanalyse kann auf der Grundlage von Mustern aus vergangenen Läufen Frühwarnzeichen erkennen. Diese Informationen ermöglichen es den Teams, einzugreifen, bevor sich ein Fehler auf eine ganze Charge auswirkt. Kundenreklamationen gehen zurück, und der First-Pass-Yield verbessert sich.

Auch Entscheidungen können schneller getroffen werden. Statt auf einen Wochenbericht zu warten, können Produktionsleiter schon während der Schicht Anpassungen vornehmen, die sich an den tatsächlichen Gegebenheiten orientieren. Aber auch hier gilt: das ist nur mit einer soliden Datengrundlage möglich. Aus diesem Grund haben Hersteller, die kontextualisierte MES-Plattformen wie FactoryLogix nutzen, einen klaren Vorteil. Diese Systeme verbinden alle Bereiche von der Entwicklung über die Ausführung bis hin zur Qualität und bieten den Teams eine Single Source of Truth.

Das versteckte Hindernis: Inkonsistente und unzuverlässige Daten

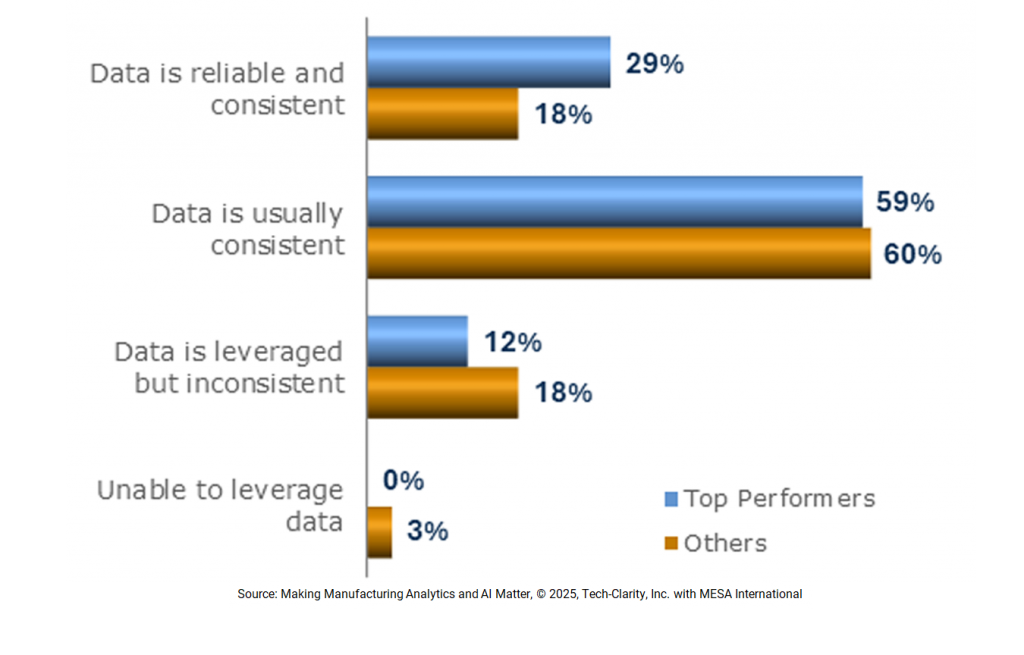

Analysen und KI sind nur so stark, wie ihre zugrundeliegenden Daten. Dennoch müssen sich die meisten Hersteller immer noch mit nicht konsistenten, unzuverlässigen oder isolierten Daten herumärgern, die selbst die fortschrittlichsten digitalen Initiativen schwächen.

Reifegrad von Manufacturing DataOps

Laut der Studie geben lediglich 29% der Top Performer und 18% der Anderen an, dass ihre Daten zuverlässig und konsistent sind. Während die meisten angeben, ihre Daten seien “in der Regel konsistent”, betont die Studie, dass dies nicht genug ist. Damit Analysen und KI Entscheidungen auf dem Shop-Floor vorantreiben können, müssen die hinter den Erkenntnissen stehenden Daten genau sowie zeitnah sein, und sie müssen vertrauenswürdig sein, nicht nur "gut genug".

Ein weiteres Problem ist der Mangel an nahtlosen Datenbewegungen innerhalb des Betriebs. Nur 38% der Top Performer geben an, dass sie operative Daten ohne manuelle Schritte bewegen können, und bei allen anderen sinkt die Zahl noch weiter. Diese Unterbrechungen des Datenflusses führen zu Reibungsverlusten, vermindern die Transparenz und verlangsamen die Entscheidungsfindung, wenn es am meisten auf Schnelligkeit ankommt.

Der Bericht schlägt einen pragmatischen Ansatz vor: fangen Sie klein an. Anstatt alle Daten auf einmal zu verbessern, sollten Sie sich darauf konzentrieren, bestimmte Datensätze im Rahmen einer bestimmten Initiative konsistent, nutzbar und gut verwaltet zu machen. Das reicht oft aus, um sofort einen Nutzen aus den Analysen zu ziehen, und schafft die Voraussetzungen für spätere, umfassendere Verbesserungen.

Hier spielen Systeme wie FactoryLogix eine Schlüsselrolle. FactoryLogix verfügt über ein einheitliches und kontextualisiertes Datenmodell und erfasst und verbindet von Anfang an Konstruktionsdaten sowie Daten aus Prozessen, Produkten, Menschen und Maschinen. Diese Art von integrierter Struktur hilft den Teams, den Daten zu vertrauen, mit denen sie arbeiten. Sie sind bereits mit den Vorgängen in der Fertigung verknüpft, so dass sie sie nicht mehr hinterfragen oder vor der Verwendung bereinigen müssen.

Von der Reaktion zur Vorhersage

Viele Hersteller versuchen, ihren Problemen voraus zu sein, anstatt nur auf diese zu reagieren. Sie setzen Alarme in Echtzeit, maschinelles Lernen und Trendanalysen ein, um Probleme zu erkennen, bevor diese sich auswachsen. Allerdings funktionieren diese Tools nur, wenn sie auf vertrauenswürdigen, qualitativ hochwertigen Daten beruhen.

Top Hersteller nutzen:

- Maschinelles Lernen zur Vorhersage von Leistungseinbrüchen oder Geräteausfällen

- Echtzeit-Analysen zur proaktiven Anpassung von Zeitplänen, zur Neuverteilung von Arbeitslasten oder zur Umleitung der Produktion auf verfügbare Ressourcen

70 % der Unternehmen geben jedoch an, dass sie nicht über genügend saubere Daten verfügen, um Vorhersagemodelle zu erstellen. Das heißt, das Hindernis ist nicht der Algorithmus, sondern der Input.

Wenn Ihr System Prozessschritte, Inspektionsergebnisse, Bedienerentscheidungen und Maschinendaten gemeinsam erfasst und in einen Kontext setzt, kann die KI beginnen, das Gesamtbild zu sehen. Wenn Ihre Daten jedoch fragmentiert sind, hilft auch das beste KI-Modell nicht weiter.

Vorhersagetools funktionieren am besten, wenn sie auf Systemen aufbauen, die von Anfang an konsistente, kontextualisierte Daten erfassen und nicht nachträglich zusammengefügt werden.

Generative KI in der Fabrikhalle

Generative KI hält allmählich Einzug in die Betriebsabläufe, aber nicht so, wie die meisten Menschen denken. Es geht nicht um auffällige, aber wenig nützliche Funktionen wie einen cleveren Chatbot in der Fertigung, sondern darum, dass die Mitarbeiter ihre Arbeit besser erledigen können, indem sie schneller Zugang zu relevanten Erkenntnissen und Anleitungen erhalten.

Hersteller erforschen Generative KI, um:

- neuen Mitarbeitern den Zugang zu Stammeswissen zu ermöglichen, ohne dass sie um Hilfe bitten müssen

- Produktions- und Qualitätsdaten zusammenzufassen, um automatisch Schichtübersichten, Inspektionshighlights und andere Betriebsberichte zu erstellen

- Korrekturmaßnahmen oder Prozessanpassungen auf der Grundlage von Mustern in historischen Daten zu empfehlen

Generative KI funktioniert aber nur dann gut, wenn die Daten, aus denen sie schöpft, bereits strukturiert und vertrauenswürdig sind. Wenn die Dokumente veraltet sind oder nicht mit den Ausführungsdaten in Verbindung stehen, wird die KI keine hilfreichen Ergebnisse liefern.

Plattformen wie FactoryLogix, auf denen alle Produktions- und Qualitätsdaten vereinheitlicht und kontextualisiert werden, machen Generative KI viel nützlicher. Bediener und Ingenieure können relevante Hinweise erhalten, ohne sich durch PDFs wühlen oder auf Berichte warten zu müssen.

Fazit

Fertigungsanalysen und KI sind nicht wegen auffälliger Funktionen erfolgreich. Sie sind erfolgreich, wenn sie auf einer soliden Grundlage strukturierter, kontextbezogener und vertrauenswürdiger Daten aufgebaut sind.

Die Unternehmen, die das meiste aus diesen Technologien herausholen, haben sich die Zeit genommen, Tools und Prozesse aufeinander abzustimmen. Sie visualisieren die Daten nicht nur, sie handeln auch danach. Sie haben die Analyse zu einem Teil des täglichen Betriebs gemacht, nicht nur zu einem monatlichen Dashboard.

Als Ausgangspunkt sollten Sie sich folgende Fragen stellen:

- Sind unsere Daten mit tatsächlichen Ereignissen, Produkten und Prozessen verknüpft oder sind sie unzusammenhängend und schwer vertrauenswürdig?

- Können unsere Bediener und Ingenieure in Echtzeit auf Erkenntnisse reagieren, oder erst im Nachhinein?

- Prüfen wir nur Berichte aus der Vergangenheit, oder nutzen wir Live-Daten, um kontinuierlich zu lernen und uns zu verbessern?

Wenn die Antworten Lücken aufzeigen, sollten Sie mit den Daten beginnen. Suchen Sie nach Lösungen, die Struktur und Kontext bieten und die Informationen denjenigen zugänglich machen, die am nächsten am Prozess dran sind, damit Entscheidungen auf der Grundlage von Vertrauen und nicht von Vermutungen getroffen werden können. Wenn Sie das tun, sind Analysen nicht mehr nur ein Berichtsinstrument, sondern ein Wettbewerbsvorteil.

Für tiefere Einblicke in die Art und Weise, wie führende Hersteller Daten in die Tat umsetzen, können Sie hier den vollständigen Bericht von Tech-Clarity & MESA International abrufen: 👉 Making Manufacturing Analytics & AI Matter

Melden Sie sich für unseren Blog an

Bleiben Sie auf dem Laufenden über die neuesten Trends, Erkenntnisse und bewährten Verfahren in der Fertigung.